机器学习模型变得越来越复杂和准确,但它们的不透明性仍然是一个重大挑战。理解为什么一个模型会做出特定的预测,对于建立信任和确保它按照预期行事至关重要。在本文中,我们将介绍LIME,并使用它来解释各种常见的模型。

LIME

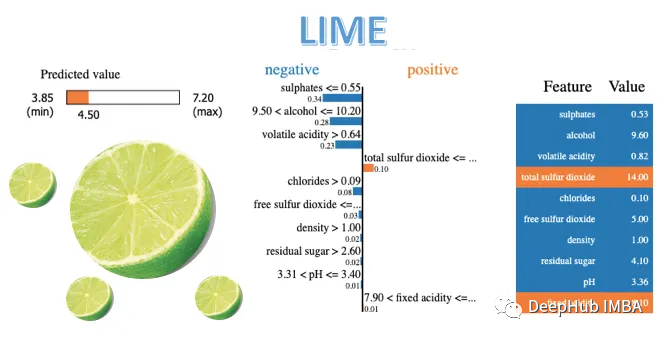

LIME (Local Interpretable Model-agnostic Explanations)是一个强大的Python库,可以帮助解释机器学习分类器(或模型)正在做什么。LIME的主要目的是为复杂ML模型做出的单个预测提供可解释的、人类可读的解释。通过提供对这些模型如何运作的详细理解,LIME鼓励人们对机器学习系统的信任。

随着ML模型变得越来越复杂,理解它们的内部工作原理可能具有挑战性。LIME通过为特定实例创建本地解释来解决这个问题,使用户更容易理解和信任ML模型。

LIME的主要特点:

- 创建简单、可解释的解释来理解复杂ML模型的预测。

- 检查单个预测来识别模型中潜在的偏差和错误。

- 理解有助于准确预测的特征来提高模型性能。

- 提供透明度和可解释性来增强用户对机器学习系统的信任。

LIME通过使用一个更简单的、围绕特定实例的本地可解释模型来近似复杂的ML模型来运行。LIME工作流程的主要可以分为一下步骤:

- 选择要解释的实例。

- 通过生成一组相邻样本来干扰实例。

- 使用复杂ML模型获得扰动样本的预测。

- 拟合一个更简单的,可解释的模型(例如,线性回归或决策树)对受干扰的样本及其预测。

- 解释更简单的模型,为原始实例提供解释。

在不同模型中使用LIME

在开始使用LIME之前,需要安装它。可以使用pip安装LIME:

pip install lime分享说明:转发分享请注明出处。