花500刀“调教”的70亿参数模型,打败700亿参数的Llama 2!

且笔记本就能轻松跑,效果媲美ChatGPT。

重点:免费、不要钱。

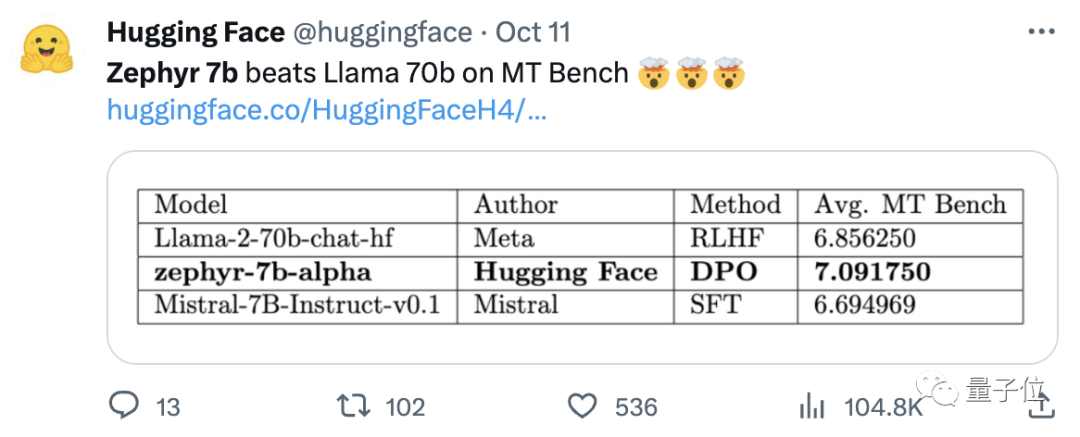

HuggingFace H4团队打造的开源模型Zephyr-7B,鲨疯了。

其底层模型是前段时间爆火、由有着“欧洲OpenAI”之称的Mistral AI打造的开源大模型Mistral-7B。

要知道,Mistral-7B发布不到2周,各种微调版本相继现世,大有Llama刚发布时迅速出现各种“羊驼”之风。

而Zephyr能够在各变种中脱颖而出,关键是团队在Mistral的基础上,使用直接偏好优化(DPO)在公开数据集上微调了模型。

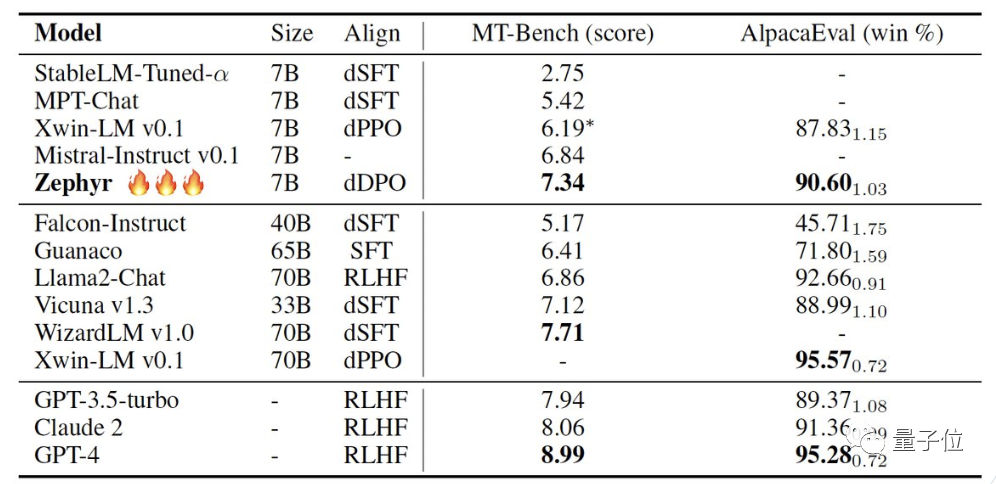

团队还发现,删除数据集的内置对齐,可以进一步提高MT Bench性能。初代Zephyr-7B-alpha的MT-Bench平均得分7.09 ,超越Llama2-70B-Chat。

△MT-Bench是评估模型处理多轮对话能力的基准测试,问题集涵盖写作、角色扮演、提取等8个类别。

关键是,它接着又升级了!

H4团队推出二代Zephyr-7B-beta。他们补充道,探索了从GPT-4、Claude 2中提取对齐性,然后将其注入小模型中的想法,开发出了将蒸馏直接偏好优化(dDPO)用于小模型的方法。

二代Zephyr,MT-Bench平均得分升高至7.34。

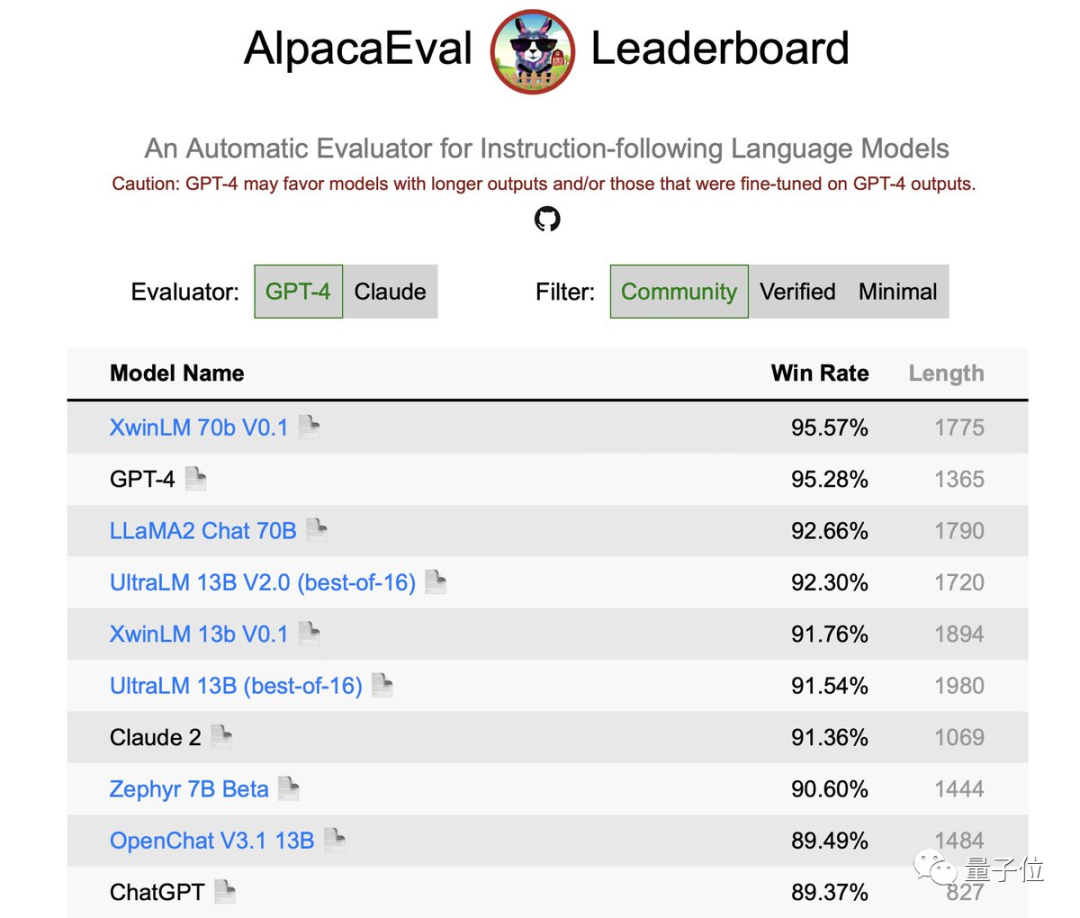

在AlpacaEval上,Zephyr胜率为90.6%,优于ChatGPT(3.5):

赶来的网友们对Zephyr给予了一致好评,lmsys团队还亮出了Zephyr-7b-beta的Elo评分,目前已飙升得很高